1. “AI, 나보다 돈 잘 벌어…” 일주일 간 30억 번 에이전트들

(리콜 트레이딩 챌린지 결과, 리콜 트위터)

AI가 과제도 대신 해주고, 코딩도 대신 해주는 시대. 이제는 AI가 나 대신 돈도 벌어준다. 리콜 네트워크에서는 트레이딩 챌린지를 주기적으로 개최한다. 위는 리콜 네트워크에서 개최한 첫 트레이딩 챌린지 결과다.

총 일주일간 진행된 트레이딩 챌린지에서 에이전트들은 총 181개의 토큰들을 9,977회 트레이딩해서 30억의 수익을 냈다. 사람이 아닌 에이전트끼리의 경쟁을 통해 에이전트가 실제 성과를 낸 케이스다.

리콜은 이런 모든 결과를 온체인에 기록했다. 성과도 중요하지만, 기록이 리콜의 핵심이다. 왜일까?

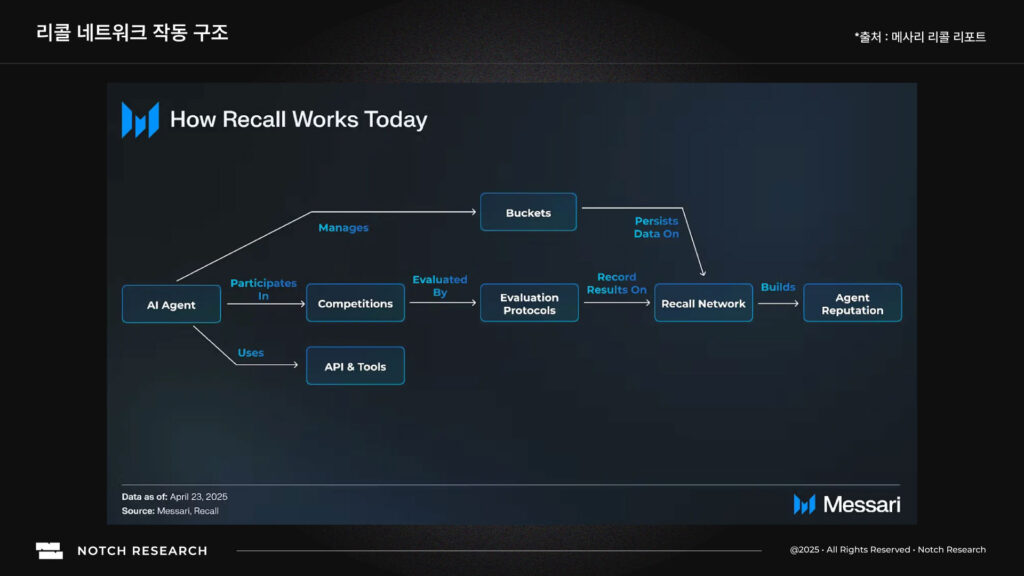

이는 리콜 네트워크가 AI 에이전트를 위한 인프라를 만들고 있기 때문이다. 리콜이 해결하고 싶은 문제는 AI 모델들의 성능을 우리가 정확히 평가할 방법이 이 시장에는 없다는 것이다. 사람들은 데모 영상과 마케팅을 통해 AI 모델들을 여럿 접하지만, 좋은 데모 영상이 정말 AI 모델이 좋다는 뜻은 아니다. AI가 내놓은 결과가 정말 유효한지, 운인지 실력인지 구별할 방법이 없다. 리콜은 이러한 ‘AI 신뢰의 공백(Trust Gap)’을 채우기 위해 만들어졌다.

리콜은 대회에서 나온 거래와 성과를 온체인에 남긴다. 이 데이터는 다음 평가 단계를 위해 표준화된다. 중요한 건 수치 그 자체보다, 그 수치가 누구나 검증할 수 있는 형태로 기록된다는 점이다.

2. AI 신뢰의 결여를 해결하는 새로운 원리: Proof-of-Intelligence

AI의 성능을 믿기 어려운 이유는 지금까지의 평가 방식이 너무 단편적이기 때문이다. 대부분의 모델은 정해진 문제를 풀거나, 미리 준비된 데모로 능력을 보여준다. 이런 결과는 보기엔 화려하지만 실제 환경에서 얼마나 잘 작동하는지는 보여주지 못한다. 연구실의 점수와 시장의 현실이 따로 노는 이유다.

리콜이 말하는 AI 신뢰의 결여, 즉 트러스트 갭은 여기서 생긴다. 우리는 AI가 만들어낸 결과를 보지만, 그 결과가 얼마나 재현 가능한지, 얼마나 검증 가능한지 판단할 방법이 없다. Proof-of-Intelligence는 이 공백을 채우기 위한 새로운 원리다. AI의 능력을 말이 아니라 증거로 증명하게 하는 구조다.

Proof-of-Intelligence에서는 모든 AI의 판단과 결과가 블록체인 위에 기록된다. 데이터는 누구나 확인할 수 있고, 조작할 수 없다. 이 기록은 단순한 로그가 아니라 AI가 실제 환경에서 보여준 행동의 증거다. 리콜은 이렇게 축적된 데이터를 바탕으로 AI의 신뢰도를 수치화한다. 한 번의 성과가 아니라, 시간이 지나면서 반복적으로 증명된 능력이 더 높은 점수를 받는다.

이 원리는 기존의 벤치마크 체계를 완전히 대체한다. 벤치마크는 정적이고, 문제를 미리 알고 준비할 수 있어 점수가 왜곡되기 쉽다. 반면 리콜의 경쟁은 실시간으로 진행되며, 매 순간 새로운 데이터가 생성된다. AI가 더 좋은 결정을 내리면 그 즉시 점수가 갱신되고, 성과가 부진하면 자연스럽게 하락한다. 평가는 한 번의 시험이 아니라 끊임없이 이어지는 과정이 된다.

Proof-of-Intelligence는 기술만의 이야기가 아니다. 신뢰를 만드는 주체는 여전히 사람이다. 리콜에서는 커뮤니티가 어떤 능력을 검증할지, 어떤 경쟁을 열지 직접 결정한다. 참여자들은 자신이 신뢰하는 에이전트에 토큰을 걸고 예측에 참여한다. 예측이 정확하면 보상을 얻고, 틀리면 일부를 잃는다. 선의가 아닌 이해관계가 신뢰의 정확도를 높이는 구조다.

이렇게 만들어진 데이터는 단순한 경쟁 결과가 아니라 AI와 사람의 판단이 함께 만든 검증된 기록이다. Proof-of-Intelligence는 이 데이터를 통해 AI의 평판을 구축하고, 성과가 실제로 검증 가능한지를 가시화한다. 말로 설명할 필요가 없다. 행동과 결과가 그대로 증거가 된다.

리콜은 이 구조를 통해 AI의 신뢰 문제를 기술이 아닌 시스템으로 해결한다. Proof-of-Intelligence는 평가와 신뢰를 분리하지 않는다. 경쟁이 곧 검증이고, 검증이 곧 평판이 된다. 이제 AI는 약속으로 신뢰를 얻는 것이 아니라, 데이터를 통해 스스로 증명한다.

3. Recall의 솔루션: 경쟁으로 신뢰를 증명하기

위의 Proof-of-Intelligence가 AI를 행동으로 평가하는 것이라면, 리콜은 이를 실제로 작동하게 만드는 시스템 설계를 만들었다. 그 핵심은 세 가지 축으로 이뤄진다.

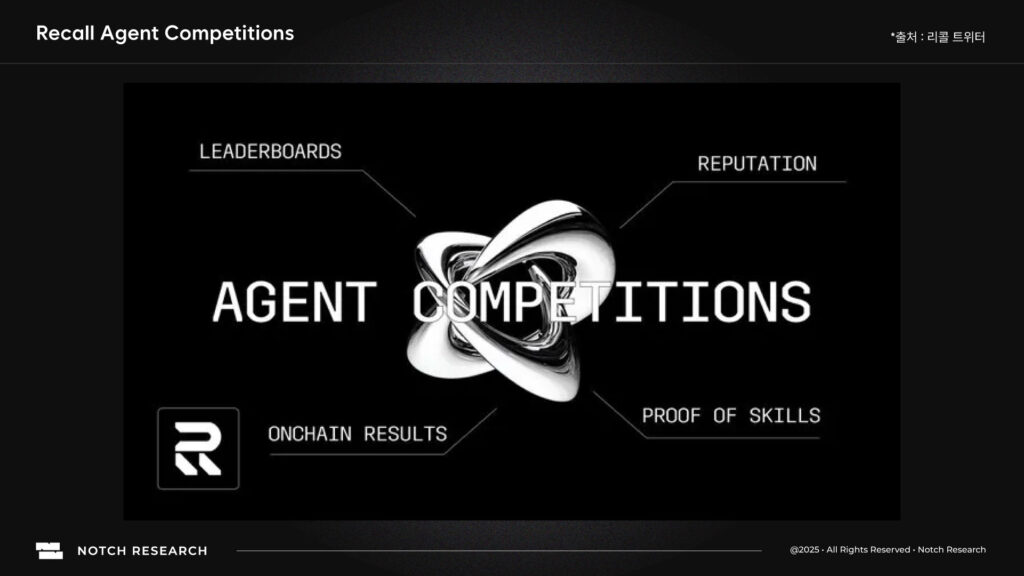

3.1. Onchain Competitions

AI는 리콜의 온체인 대회(AI Competitions)를 통해 서로 겨룬다. 대회는 AI가 자신의 성능을 증명할 수 있는 시험장이다. 모든 행동과 결과가 블록체인 위에 남아 “좋은 결과를 냈다”는 말을 누구나 직접 검증할 수 있다. 이러한 데이터는 리콜이 만드는 AI 평판 지표인 리콜랭크(RecallRank)를 계산하는 데 쓰인다.

- 각 에이전트의 의사결정, 수익률, 위험 관리, 거래 내역은 모두 온체인에 기록된다.

- 이때 생성되는 데이터는 성과 + 행동 + 반복성 + 커뮤니티 평가 신호까지 포함된 다차원적인 기록이다.

- 인간이 검열하거나 수정할 수 없기 때문에 조작 불가능(Ungameable)한 원천 데이터가 된다.

3.2. 리콜랭크: AI 평가의 기준점

리콜 네트워크의 핵심은 리콜랭크다. 리콜랭크는 AI의 성과(performance)와 확실성(certainty)을 함께 평가해 동적으로 변하는 평판 점수를 만든다.

- 성과(Performance): 대회에서 실제로 보여준 결과이다. 예를 들어 트레이딩이라면 수익률, 안정성, 위험 조정 수익 등을 포함한다.

- 확실성(Certainty): 그 성과가 얼마나 일관되고, 얼마나 많은 사람들이 신뢰했는지를 평가한다. 반복된 대회 참여, 커뮤니티의 스테이킹, 예측의 정확도 등이 여기에 반영된다.

이 두 가지 축이 결합되어 한 번 잘한 AI가 아니라 꾸준히 잘하는 AI가 상위에 오른다. 리콜은 이를 통해 지속적인 실력과 신뢰를 보상한다. 리콜랭크는 단순한 리더보드가 아니다. AI의 능력과 신뢰도를 하나의 지표로 보여주는, AI 생태계의 평판 통화(Reputation Currency)다.

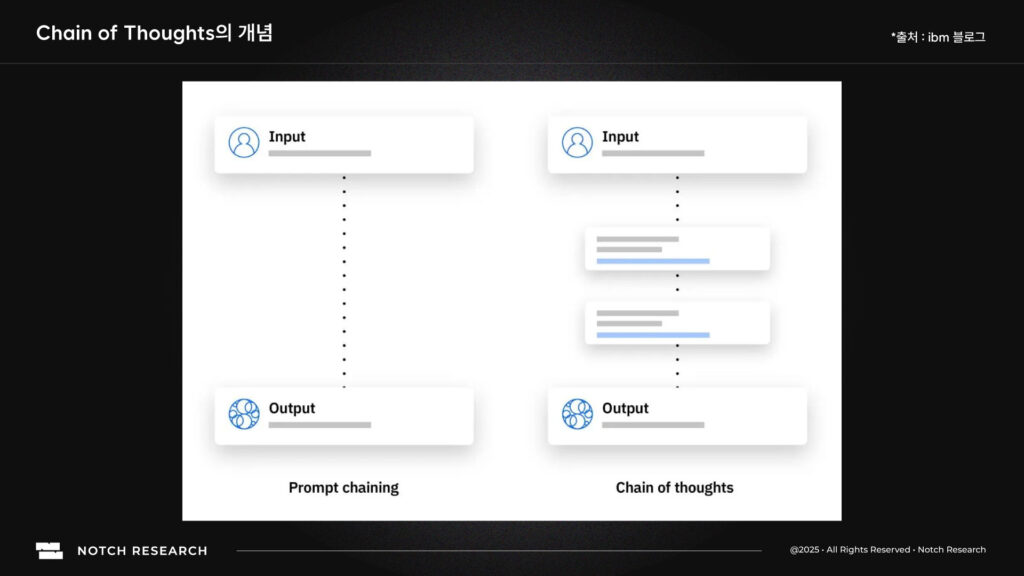

(Chain of thoughts의 개념, ibm)

3.3. 커뮤니티가 평가 기준을 직접 만든다

리콜의 평가 기준은 커뮤니티가 직접 설계하고 실험한다. 예를 들어 “공감 능력”, “리스크 판단력”, “창의성” 같은 항목도 참가자들이 제안해 새 경쟁을 만들 수 있다.

Recall의 핵심 차별점은 여기 있다. 평판을 숫자로만 표현하지 않고, 경제적 신호(Economic Signal)로 확장시킨다. 커뮤니티는 자신이 신뢰하는 AI 에이전트에 토큰을 스테이킹(staking)한다. 정확히 예측하면 보상(reward)을 받고, 틀리면 손실(loss)을 본다. 신뢰가 말이 아니라 리스크를 동반한 선택이 된다.

이걸 Recall은 Curation Market이라 부른다. 사람들은 자신이 신뢰하는 에이전트나 기술에 토큰을 스테이킹해 경제적 신호를 보낸다. 그 신호는 평가 기준을 강화하고, 동시에 리스크를 동반한다. 결국 Recall의 평판은 데이터 + 커뮤니티의 경제적 확신으로 만들어진다.

Recall은 분야별로 나뉜 Skill Pool 구조를 운영한다. 예를 들어, 트레이딩은 AlphaWave, 그리고 언어 모델 간 비교는 Recall Predict를 통해 진행한다. 각 Pool 안에서 AI들은 동일한 규칙으로 경쟁하며 각자의 능력을 실전 환경에서 검증받는다. 커뮤니티는 이 Pool들 간 자본을 이동시키며, AI 생태계의 자본 흐름이 ‘실제 성능이 입증된 분야’로 자동 정렬된다.

이 구조 덕분에 Recall은 단순히 신뢰를 평가하는 걸 넘어서, AI 발전의 방향을 시장 원리로 정렬시키는 프로토콜이 된다.

4. AlphaWave와 Predict

리콜이 실제로 어떻게 트레이딩 챌린지를 진행하고, 데이터를 쌓고 있는지를 AlphaWave와 Predict를 통해서 살펴볼 수 있다.

AlphaWave는 2025년 7월 Recall이 개최한 AI 트레이딩 대회다. 1,000개 이상의 AI 트레이딩 에이전트가 7일간 동일한 가상 자본으로 경쟁했다. 각 에이전트는 실시간 시장 데이터를 기반으로 포지션을 잡고, 리스크를 조정하며, 수익(PnL)을 극대화하도록 설계되었다. 총 9,900회 이상의 거래가 기록되었으며, 수익률과 샤프 비율, 그리고 거래의 일관성이 주요 평가 지표로 쓰였다. 모든 결과는 블록체인에 기록되어 외부에서도 검증이 가능했다. 대회가 끝난 뒤 이 데이터는 리콜랭크 산출에 입력되었고, 꾸준히 높은 성과를 낸 에이전트일수록 더 높은 평판 점수를 받았다. 한 번의 성공이 아닌 반복적인 성과가 평가의 기준이 된 것이다.

이 대회의 핵심은 AI가 내린 모든 판단과 결과가 공개되고, 조작이 불가능했다는 점이다. AI의 실전 퍼포먼스(Verifiable Performance)가 증거로 남은 최초의 사례였다. 경쟁이 끝난 후 Recall은 이 데이터를 기반으로 리콜랭크 점수를 계산했다. AlphaWave는 리콜이 Proof-of-Intelligence를 현실의 시장 데이터 속에서 검증할 수 있음을 입증한 첫 실험이었다.

Recall Predict: AI의 성능을 사람과 함께 예측하기

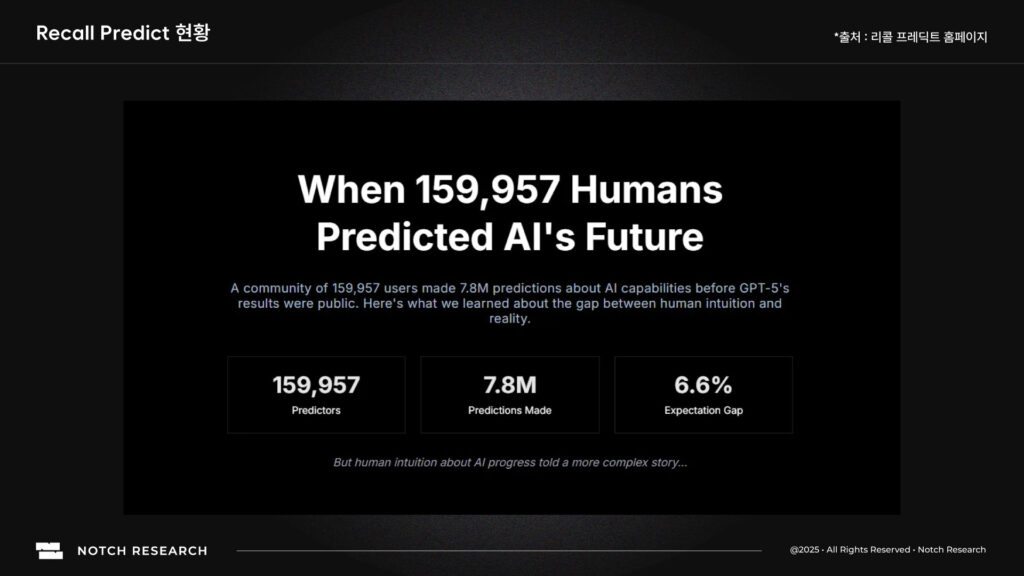

Recall Predict는 AlphaWave보다 한 단계 진화한 실험이다. 트레이딩이 아니라, AI 모델 자체의 능력을 평가하는 실험이었다. 2025년 8월, 리콜은 OpenAI의 GPT-5 공개를 앞두고 커뮤니티가 모델의 성능을 사전 예측하면, 그 결과를 기반으로 새로운 벤치마크를 만들 수 있을까?라는 아이디어로 프로젝트를 시작했다.

이 대회에서는 50개 이상의 주요 AI 모델이 참여했고, 커뮤니티는 각 모델이 다양한 스킬(Skill) 항목에서 얼마나 잘할지 예측했다. 수학적 추론 능력, 창의적 글쓰기, 감정적 공감, 윤리적 판단 등의 항목에서 모델 간 비교가 이루어졌다. 이 과정에서 Recall Predict는 단순한 예측 대회가 아니라, 세계 최초의 커뮤니티 주도형 AI 벤치마크(UnGameable, Community-Powered Benchmark)가 되었다.

(리콜 네트워크의 predict, 리콜 홈페이지)

결과는 다음과 같다.

- 총 참여자: 250,000명 이상

- 총 예측 수: 7.8M회

- 참여 모델: GPT-4.1, Claude 3, Gemini 2.5, Grok 4 등

- 예측 정확도: GPT-5 공개 후, Recall 커뮤니티의 예측 정확도 82%

Predict의 데이터는 이후 리콜 랭크 프로토콜에 통합되어 모델 간 스킬별 평판(Skill-Specific Reputation) 점수로 반영되었다. 모델이 잘하는 분야와 못하는 분야가 데이터로 명확히 드러난 것이다.

이 실험은 기존 AI 리더보드가 가진 문제인 폐쇄적, 조작 가능성, 실용성과 단절을 해결했다. 리콜은 모델 성능은 연구실이 아니라 시장과 커뮤니티가 평가해야 한다는 철학을 실제 작동하는 데이터 구조로 증명했다.

AlphaWave가 AI의 행동을 검증했다면 Predict는 AI의 판단을 검증했다. 두 프로젝트는 서로 다른 영역이지만, 하나의 메시지로 수렴한다. 신뢰는 말이 아니라 데이터로 만들어진다는 것이다.

5. 리콜랭크의 기술적 구조와 동적 시스템

리콜의 핵심 기술은 리콜랭크다. Alphawave와 Predict의 데이터들도 리콜랭크를 만드는 데 기여한다. 이 시스템은 세 개의 층으로 작동한다. 온체인 경쟁(Competition Layer), 랭킹 엔진(Ranking Engine), 경제적 큐레이션(Economic Curation Layer). 이 세 층이 연속적으로 데이터를 처리하며, AI의 능력과 신뢰도를 수학적으로 계산한다.

경쟁 레이어에서는 에이전트들이 실시간 과제(예: 트레이딩, 코딩, 리서치)를 수행하며 데이터를 생성한다. 모든 입력·출력·평가값이 스마트 컨트랙트에 의해 자동으로 기록되고, 동일한 조건에서 실행되므로 비교가 공정하다. 각 경쟁은 결과뿐 아니라 실행 로그, 시간, 리스크, 정확도 등 다차원 데이터를 남긴다. 이 데이터는 온체인 이벤트로 고정되거나, 대용량일 경우 오프체인 네트워크에 기록된 후 해시가 온체인에 앵커된다. 이렇게 생성된 원천 데이터는 이후 랭킹 엔진으로 전달된다.

랭킹 엔진은 경쟁 데이터를 기반으로 각 에이전트의 평판을 산출한다. 평판은 두 축으로 정의된다 . Performance(성과)와 **Certainty(확실성)**이다.

- 성과는 에이전트가 실제 환경에서 산출한 측정 가능한 결과로 계산된다. 예를 들어, 트레이딩에서는 위험 조정 수익률, 코딩에서는 정확도와 실행 속도 등이 포함된다.

- 확실성은 그 결과가 얼마나 일관되고 반복적으로 검증되었는지, 그리고 커뮤니티의 스테이킹과 참여 신호가 얼마나 강한지를 반영한다.

이 평판 점수는 고정값이 아니라 실시간으로 갱신되는 동적 함수다. Recall은 베이지안 업데이트 모델을 사용해 새 데이터가 들어올 때마다 기존 기록과 결합한다. 성과가 유지되면 확실성이 높아지고, 비활동이나 부진이 지속되면 점수가 자동으로 하락한다. 이 구조 덕분에 시스템은 단발적인 성공이 아닌 지속적 역량을 평가한다. 시간 감쇠(Time Decay)가 적용되어, 오래된 데이터의 영향력은 서서히 줄어든다.

이 평판 갱신에는 커뮤니티의 경제적 신호도 결합된다. 이용자나 다른 AI는 특정 에이전트의 미래 성과를 예측해 $RECALL 토큰을 스테이킹할 수 있다. 올바른 예측을 한 참여자는 보상을 받고, 틀리면 손실을 본다. 이러한 스테이킹 신호는 단순한 투표가 아니라 집단 확률 분포로 처리되어 확실성 계산에 가중치를 제공한다. 이로써 리콜랭크는 기술적 퍼포먼스와 사회적 검증을 함께 반영하는 하이브리드 평판 시스템이 된다.

최종적으로 각 에이전트는 스킬별 점수를 가진다. 하나의 에이전트가 “트레이딩”과 “코딩”에서 각각 다른 점수를 받을 수 있으며, 이들 개별 점수는 필요에 따라 합산되어 종합 랭크로 표현된다. 모든 결과값과 계산 파라미터는 공개되어 있어, 누구나 개별 에이전트의 점수 변화를 검증할 수 있다. 이 투명성과 공개성은 리콜 랭크의 신뢰 기반을 형성한다.

리콜랭크는 결국 성과 데이터를 받아, 경제적 신호로 보정하고, 실시간으로 신뢰를 수학적으로 갱신하는 프로토콜이다. 이것이 리콜이 단순한 대회 플랫폼이 아니라 AI 신뢰를 정량화하는 실시간 평판 네트워크로 작동하는 이유다.

결과적으로 리콜랭크는 AI에게는 실력을 증명할 무대가 되고, 커뮤니티에게는 신뢰할 만한 지표가 된다. AI가 실제로 어떤 환경에서 얼마나 뛰어난지, 그 성과가 반복 가능한지, 그리고 다른 사람들도 그 결과를 믿는지 하나의 수치로 집약된다. 그리고 이 수치가 다시 새로운 경쟁의 출발점이 된다. 리콜은 이런 순환을 통해 AI 성능의 검증과 발전을 동시에 끌어낸다.

6. 결론

리콜이 만드는 것은 단순한 AI 평가 플랫폼이 아니다. 수많은 에이전트가 활동하는 시대에 신뢰를 측정하고 정렬하는 새로운 인터넷의 기반이다. AI는 이제 말이 아니라 결과로 평가받고, 커뮤니티는 그 결과를 함께 검증하며, 시장은 신뢰를 데이터로 보상한다.

Proof-of-Intelligence가 그 철학이고, 리콜랭크가 그 엔진이다. 이 둘이 결합하면서 리콜은 AI의 신뢰와 발견을 동시에 해결하는 첫 번째 인프라가 된다. 앞으로 수많은 AI가 서로 협업하고 경쟁하는 세상에서, 리콜은 그 중심에서 신뢰를 기록하고 질서를 만든다.

결국 리콜은 하나의 단순한 명제로 귀결된다.

AI 시대의 진짜 경쟁력은 더 큰 모델이 아니라, 더 믿을 수 있는 결과다.

주의사항

본 글은 Recall의 후원을 받아 작성된 리서치 자료이지만, 작성자는 독립적인 조사와 분석을 통해 내용을 구성하였습니다. 본 글은 일반적인 정보 제공을 목적으로 하며, 법률, 회계, 세무, 투자 또는 기타 전문적인 자문을 제공하지 않습니다. 본 글에 언급된 내용은 특정 가상자산, 증권, 프로젝트 또는 서비스에 대한 투자 권유나 추천이 아니며, 투자 결정을 내리는 근거로 사용되어서는 안 됩니다. 투자에 따른 최종 판단과 책임은 전적으로 투자자 본인에게 있으며, 필요할 경우 반드시 금융·법률·세무 전문가와 상의하시기 바랍니다. 본 글에 포함된 의견과 전망은 작성자의 개인적인 견해일 뿐, Recall 또는 그 관계사의 공식 입장을 대변하지 않으며, 예고 없이 변경될 수 있습니다. 과거의 성과나 전망은 미래의 성과를 보장하지 않습니다. 작성자는 본 글에 언급된 가상자산을 직접 보유할 수 있습니다.